Di pusat data hari ini, perhatian utamanya adalah IOPS, bukan kapasitas disk.

Dengan peralatan penyimpanan yang berbasiskan harddisk, performa penyimpanan sangat sulit tercapai. Ini alasannya: Ketika seorang pengguna memutuskan untuk menyimpan dokumen, komponen mekanis di dalam hard drive tempat dokumen itu disimpan akan mulai beraksi. Bagian kepala untuk menulis yang bertanggung jawab untuk menyimpan data tersebut, memposisikan dirinya hanya berjarak setipis sehelai rambut di atas lempengan magnet yang berputar antara 7.200 dan 15.000 putaran per menit. Setelah berada di posisinya, bagian kepala tersebut mulai menulis file untuk kemudian disimpan. Namun, mungkin tidak ada cukup tempat pada lempengan itu untuk menuliskan semua file sekaligus; jadi bagian kepala itu akan menyimpan sebagian file di seluruh kepingan disk dan kemudian menyimpan indeks komprehensif sehingga ia tahu di mana potongan potongan setiap file disimpan.

Semakin banyak waktu yang diperlukan untuk mencatat file, semakin lama pengguna harus menunggu komputer menyimpan file. Waktu antara perintah untuk menulis file dan kepastian bahwa file telah dicatat itu disebut sebagai latensi. Latensi adalah salah satu masalah paling serius di pusat data saat ini, dan masalah yang kompleksnya dipengaruhi oleh jenis aplikasi baru yang memasuki pasar aplikasi bisnis. Banyak aplikasi baru memperkenalkan persyaratan kinerja pada sistem penyimpanan yang justru meningkatkan latensi. Akhirnya, latensi menjadi sangat buruk sehingga merugikan operasi bisnis yang sedang berlangsung.

Untuk mengatasi masalah yang terus berkembang ini, jenis penyimpanan baru telah hadir di pasaran. Disebut penyimpanan flash atau penyimpanan solid-state, penyimpanan jenis ini tidak mengalami kesulitan latensi yang mengganggu hard drive tradisional. Namun, jika hard drive modern masing-masing dapat menyimpan 6 terabyte (6 triliun byte) atau lebih per disk, disk solid-state dapat menyimpan hanya sebagian kecil dari jumlah tersebut (1 TB atau 1 triliun byte, sebagai contoh). Lagipula, disk solid-state tetap relatif mahal dibandingkan dengan hard disk yang diperuntukkan untuk kapasitas.

Teknologi efisiensi data yang dikembangkan untuk peranti yang dijelaskan di bagian sebelumnya secara historis dirancang untuk mengatasi masalah kapasitas. Sejak HDD menambahkan biaya, sejumlah peralatan dikembangkan untuk tujuan menghemat kapasitas sebanyak mungkin pada HDD dengan mengorbankan sumber daya CPU. Tapi seperti yang baru saja kita bahas, tantangan sesungguhnya adalah IOPS.

Sama seperti pilihan teknologi disk yang memiliki kekurangannya, penggunaan teknologi efisiensi data yang berbeda juga memiliki kekurangan.

Kompresi

Kompresi adalah proses mengurangi ukuran elemen data yang diberikan. Tidak semua data dapat dikompresi — misalnya, sebagian besar file video atau audio tidak bisa — sementara teks dapat dikompres dengan sangat baik. Tantangannya adalah tidak ada cara untuk mengetahui dengan tepat seberapa baik data yang akan dikompresi tanpa melakukan kompresi terlebih dahulu.

Kompresi Inline

Kompresi inline terjadi sebelum data dimasukkan ke disk. Meskipun membutuhkan IOPS yang lebih sedikit dan kapasitas yang lebih sedikit, itu meningkatkan latensi dan mengkonsumsi CPU berlebih.

- Sumber daya intensif, membutuhkan sejumlah CPU yang besar

- Proses memakan waktu meningkatkan latensi

- Manfaat: Pengurangan kapasitas HDD yang digunakan

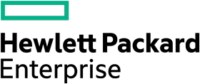

Kompresi pasca-proses

Pasca-proses menunda kompresi untuk mengurangi kebutuhan kapasitas penyimpanan secara signifikan. Sistem menulis data ke disk, kemudian membaca kembali data dari disk dan mencoba untuk memanfaatkannya. Ini secara signifikan meningkatkan IOPS dan konsumsi CPU.

- IOPS disk tambahan diperlukan setelah memulai kinerja untuk membaca dan kemudian berpotensi untuk menulis ulang data

- CPU diperlukan setelah pencatatan awal untuk membaca data

- CPU diperlukan untuk memproses data

- Banyak IOPS dibutuhkan untuk mencatat data masuk ke disk

- Keuntungan: Penghematan Kapasitas penyimpanan disk

Deduplikasi

Deduplication adalah teknik efisiensi data khusus yang digunakan untuk meningkatkan pemanfaatan penyimpanan. Teknik ini mengidentifikasi dan menyimpan hanya potongan data yang unik, atau pola byte, menghilangkan duplikat salinan data. Sebagian besar sistem deduplikasi hanya satu fase dari siklus hidup data dan biasanya perlu menghapusnya dari keadaan terdeduplikasi untuk memindahkannya ke fase lain.

Deduplikasi Inline

Seperti kompresi inline, inline deduplication terjadi sebelum data dicatat. Tujuannya adalah untuk menghapus redudansi dan kapasitas yang diperlukan untuk menyimpan data yang berlebihan.

- Memberikan peringatan kinerja pada semua I/O karena membutuhkan sumber daya CPU dan memori yang signifikan

- Sistem penyimpanan: Data pertama kali dibaca oleh aplikasi ke server, lalu ditransfer melalui jaringan area penyimpanan ke seluruh tempat

- Sistem backup: Data pertama kali dibaca ke server dan penyimpanan terlebih dahulu sebelum dibackup dan diduplikasi pada perangkat backup

- Manfaat: Pengurangan kapasitas disk yang digunakan

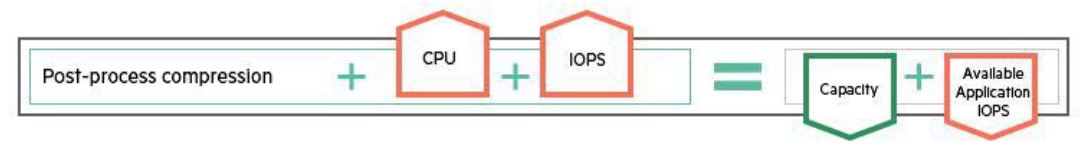

Deduplikasi pasca-proses

Di dalam post-process deduplication, data pertama kali dicatat ke disk dan kemudian dideduplikasi di lain waktu. Sekali lagi, tujuannya adalah untuk mengurangi kebutuhan kapasitas disk, tetapi akan membutuhkan biaya CPU dan IOPS yang besar.

- Membutuhkan ruang yang cukup di awal terlebih dahulu untuk memasukkan data sebelum deduplikasi

- Membutuhkan IOPS tambahan untuk mancatat data, kemudian membaca data untuk di deduplikasi, lalu kemudian mencatat kembali dalam bentuk duplikat

- Membutuhkan tambahan bandwidth SAN untuk mentransfer blok di sekitar kabel sebelum terjadi deduplikasi

- Manfaat: Pengurangan kapasitas disk yang digunakan akhirnya akan dikenali

Masing-masing teknologi efisiensi data yang dijelaskan pada bagian sebelumnya memiliki beberapa kelemahan mendasar yang sama:

- Mereka membutuhkan hal yang dikorbankan — apakah itu mengorbankan CPU di awal atau IOPS di bagian akhir, sumber daya yang mahal terbuang percuma, mungkin dengan mengorbankan kinerja aplikasi.

- Mereka memiliki biaya tersembunyi — Dalam lingkungan hyperconverged, lebih banyak sumber daya CPU mungkin diperlukan untuk mendukung kinerja aplikasi, yang bisa berarti lebih banyak hypervisor dan biaya lisensi database.

- Mereka dirancang untuk kapasitas — Teknologi ini dirancang untuk memecahkan permasalahan kapasitas, bukan masalah IOPS, oleh karena itu kinerja sering dikorbankan.

- Mereka dirancang untuk masing-masing tahapan pada data — Setiap teknologi saat ini diterapkan di satu perangkat pada waktu yang sudah disesuaikan. Setiap kali data dipindahkan ke tahap berikutnya dalam siklus hidupnya, itu perlu diproses terus-menerus.

Semua ini menunjuk ke satu solusi yang jelas untuk masalah data: Untuk memiliki proses yang benar-benar efisien, data harus dideduksi, dikompresi, dan dioptimalkan pada awal pemprosesan, dan dipelihara dalam keadaan itu melalui seluruh siklus hidup dari data itu. Ketika data dihapus proses duplikasi akan dilakukan dari awal di setiap titik, ia

memiliki faktor penghasil sumber daya yang signifikan di bagian hilir, dan membuka fungsi lanjutan yang dibutuhkan di dunia virtualisasi saat ini.